io.net 是 IO Research 开发的基于 Solana 的去中心化 AI 算力平台,在其最新一轮融资中达到了 10 亿美元的 FDV 估值。

io.net 在今年 3 月宣布在 Hack VC 的领投下完成了 3000 万美元的 A 轮融资,其中还包括 Multicoin Capital、6th Man Ventures、Solana Ventures、OKX Ventures、Aptos Labs、Delphi Digital、The Sandbox 和 The Sandbox 的 Sebastian Borget 等参与。

io.net 专注于为 AI 和机器学习公司聚合 GPU 资源,致力于以更低的成本和更快的交付时间提供服务。自去年 11 月启动以来,io.net 已经增长到超过 25,000 个 GPU,并为人工智能和机器学习公司处理了超过 40,000 个计算小时。

io.net 的愿景是构建一个全球化的去中心 AI 计算网络,为 AI 与机器学习团队/企业与世界各地的强大 GPU 资源之间搭建生态系统。

在这个生态系统中,AI 计算资源变得商品化,供需双方不再会因为没有资源而困扰。未来 io.net 还将提供访问 IO 模型商店和高级推理功能,如无服务器推理、云游戏和像素流等服务。

在介绍 io.net 的业务逻辑之前,我们先要从两个维度了解去中心化算力这一赛道:一个是 AI 计算的发展历程,另一纬度是了解过去同样使用去中心化算力的案例。

我们可以从几个关键时间点来描绘这 AI 计算的发展轨迹:

在这一时期,机器学习方法主要集中在较为简单的模型,如决策树、支持向量机(SVM)等。这些模型的计算需求相对较低,可以在当时的个人计算机或者小型服务器上运行。数据集相对较小,特征工程和模型选择是关键任务。

2006 年,深度学习的概念被重新引入,这一时期以 Hinton 等人的研究为标志。随后,深度神经网络,特别是卷积神经网络(CNN)和循环神经网络(RNN)的成功应用,标志着这一领域的突破。这一阶段对计算资源的需求显著增加,尤其是在处理图像和语音等大数据集时。

随着 BERT(2018 年)和 GPT 技术(2018 年以后)的出现,大模型开始主导 AI 赛道。这些模型通常具有数十亿至数万亿的参数,对计算资源的需求达到了前所未有的水平。训练这些模型需要大量的 GPU 或是更专业的 TPU,并且需要大量的电力和冷却设施支持。

从过去 30 年 AI 对算力需求的指数级增长来看,早期机器学习对算力的需求较低,深度学习时代增加了对算力的需求,而 AI 大型模型进一步将这一需求推向极致。我们见证了计算硬件从数量到性能的显著提升。

这种增长不仅反映在传统数据中心的规模扩大和 GPU 等硬件性能的提高上,更体现在高昂的投入门槛以及丰厚的回报预期,足以让互联网巨头间的厮杀公开化。

传统的中心化 GPU 算力中心,初期投资需要昂贵的硬件采购(如 GPU 本身)、数据中心的建设或租赁费用、冷却系统以及维护人员的成本。

相比之下,io.net 所建立的去中心化计算平台项目在搭建成本方面具有明显的优势,能显著降低初期投资和运营成本,可以为小微团队建立自己的 AI 模型创造了可能。

去中心化 GPU 项目利用已存在的分布式资源,不需要集中投资于硬件和基础设施建设。个人和企业可以将闲置的 GPU 资源贡献到网络中,减少了集中采购和部署高性能计算资源的需要。

其次,在运营成本方面,传统的 GPU 集群需要持续的维护、电力和冷却费用。而去中心化 GPU 项目通过利用分布式的资源,可以将这些成本分摊给各个节点,从而降低单一组织的运营负担。

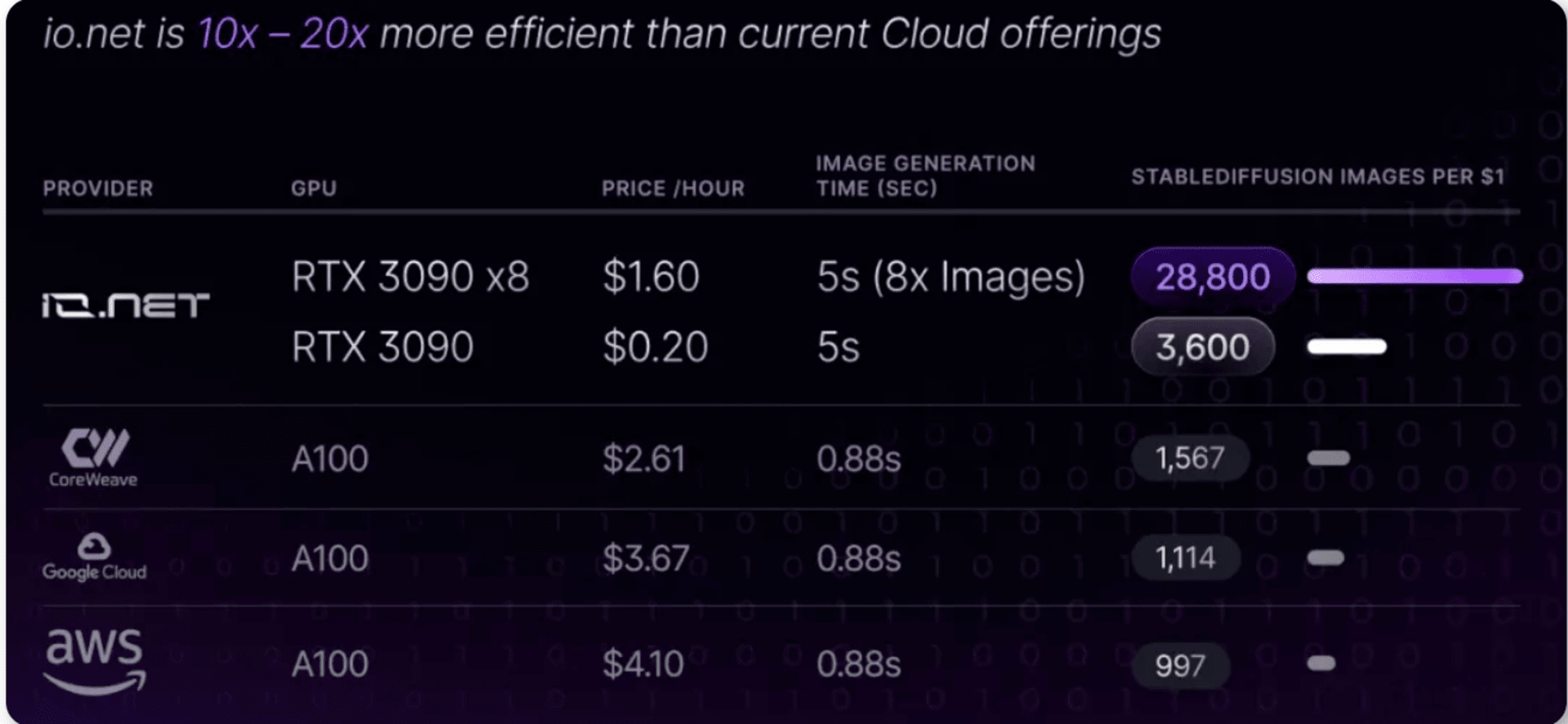

根据 io.net 的文档,io.net 通过聚合来自独立数据中心、加密货币矿工以及 Filecoin、Render 等其他硬件网络中未充分利用的 GPU 资源极大降低了运营成本。再加上 Web3 的经济激励策略,使得 io.net 在定价上拥有极大优势。

io.net 与当前主流云服务厂商对比

回顾历史,过去确实有一些去中心化计算项目取得了显著的成功,在没有经济激励的情况下,依旧吸引了大量参与者并产生了重要成果。比如:

Folding@home:这是一个由斯坦福大学发起的项目,旨在通过分布式计算来模拟蛋白质折叠过程,帮助科学家了解疾病机理,尤其是与蛋白质折叠不当相关的疾病如阿尔茨海默病、亨廷顿病等。在 COVID-19 疫情期间,Folding@home 项目聚集了海量的计算资源,以帮助研究新冠病毒。

BOINC (Berkeley Open Infrastructure for Network Computing)**:这是一个开源软件平台,支持各种类型的志愿者和网格计算项目,包括天文学、医学、气候科学等多个领域。用户可以贡献闲置的计算资源,参与到各种科研项目中。

这些项目不仅证明了去中心化计算的可行性,也展现了去中心化计算的巨大发展潜力。

通过动员社会各界贡献未利用的计算资源,能显著增强计算能力,如果再创新地加入 Web3 的经济模型,还能在经济上实现更大的成本效益。Web3 经验表明,一个合理的激励机制对于吸引和维持用户的参与。

通过引入激励模型可以构建一个互助共赢的社区环境,可以进一步促进业务规模扩大,正向循环推进技术进步。

因此,io.net 能够通过激励机制的引入,吸引广泛的参与者,共同贡献算力,形成一个强大的去中心化计算网络。

Web3 的经济模型与去中心化算力潜力为 io.net 提供了强大增长动力,并实现高效的资源利用和成本优化。这不仅促进了技术创新,也为参与者提供了价值,可以使 io.net 在 AI 领域的竞争中脱颖而出,拥有巨大的发展潜力和市场空间。

GPU 集群是指复杂的计算通过网络将多个 GPU 连接起来,形成一个协作的计算集群,这种方法大幅提升了处理复杂 AI 任务的效率和能力。

集群计算不仅加快了 AI 模型的训练速度,还增强了处理大规模数据集的能力,使得 AI 应用更加灵活和可扩展。

在传统互联网训练 AI 模型的过程中,都需要用大规模的 GPU 集群。然而,当我们考虑将这种集群计算模式转向去中心化时,一系列技术挑战随之浮现。

相比与传统的互联网公司的 AI 计算集群,去中心化的 GPU 集群计算,会面对更多问题,比如:节点可能遍布不同地理位置,这带来了网络延迟和带宽限制问题,可能影响到数据在节点间的同步速度,从而影响整体的计算效率。

此外,如何保持数据在各个节点间的一致性和实时同步,也对于确保计算结果的准确性至关重要。因此这就需要去中心化计算平台开发出高效的数据管理和同步机制。

而如何管理和调度分散的计算资源,确保计算任务能够有效完成,也是去中心化集群计算需要解决的问题。

io.net 通过集成 Ray 和 Kubernetes,构建了一个去中心化的集群计算平台。

Ray 作为一个分布式计算框架,直接负责在多个节点上执行计算任务,它优化了数据处理和机器学习模型的训练过程,确保了任务在各个节点上高效运行。

而 Kubernetes 则在这一过程中扮演着关键的管理角色,它自动化了容器应用的部署和管理,确保了计算资源根据需求动态地分配和调整。

在这个体系中,Ray 和 Kubernetes 的结合实现了一个动态且弹性的计算环境。Ray 确保计算任务能够在适当的节点上高效执行,而 Kubernetes 保证了整个系统的稳定性和可扩展性,自动处理节点的增加或移除。

这种协同作用使得 io.net 能够在去中心化的环境中提供连贯且可靠的计算服务,无论是在数据处理还是模型训练方面,都能够满足用户的多样化需求。

通过这种方式,io.net 不仅优化了资源的使用,降低了运行成本,还提高了系统的灵活性和用户的控制度。用户可以便捷地部署和管理各种规模的计算任务,而无需担心底层资源的具体配置和管理细节。

这种去中心化的计算模式,借助 Ray 和 Kubernetes 的强大功能,确保了 io.net 平台在处理复杂和大规模计算任务时的高效性和可靠性。

由于去中心化的集群的任务调配逻辑的使用场景远比机房中的集群逻辑要复杂得多,又鉴于数据和计算任务在网络中的传输增加了潜在的安全风险,去中心化的集群还要考量安全性和隐私保护。

io.net 通过利用网状(mesh)私有网络通道的去中心化特性,提升了网络的安全性和隐私性。在这样的网络中,由于没有中心集中点或网关,网络面临的单点故障风险大幅降低,即使部分节点遇到问题,整个网络仍能保持运行。

数据在网状网络内沿多条路径传输,这种设计增加了追踪数据源或目的地的难度,从而加强了用户的匿名性。

此外,通过采用诸如数据包填充和时间混淆等技术(Traffic Obfuscation),网状 VPN 网络能进一步模糊数据流动的模式,使得窃听者难以分析流量模式或识别特定用户或数据流。

io.net 的隐私机制之所以能有效解决隐私问题,是因为它们共同构建了一个复杂且多变的数据传输环境,使得外部观察者难以捕捉到有用的信息。

同时,去中心化结构避免了所有数据流经单一点的风险,这种设计不仅提高了系统的鲁棒性,也降低了被攻击的可能性。同时,数据的多路径传输和流量的混淆策略共同为用户的数据传输提供了一层额外的保护,增强了 io.net 网络的整体隐私性。

IO 是 io.net 网络的原生加密货币和协议通证,可以满足生态系统内两大主体的需求:AI 初创公司和开发者,以及算力提供者。

对于 AI 初创公司和开发者而言,IO 简化了集群部署的支付流程,更加方便;他们还可以使用与美元挂钩的 IOSD Credits 来支付网络上计算任务的交易费用。每个在 io.net 上部署的模型都需要通过微小的 IO 币交易进行推断。

对于供应商来讲,特别是 GPU 资源的提供者,IO 币保证了他们的资源得到公平的回报。不论是 GPU 被租用时的直接收益,还是在空闲时参与网络模型推断的被动收益,IO 币都为 GPU 的每一份贡献提供了奖励。

在 io.net 生态系统中,IO 币不仅是支付和激励的媒介,还是治理的关键。它让模型开发、训练、部署和应用开发的每一个环节都更加透明、高效,并确保了参与者之间的互利共赢。

通过这种方式,IO 币不仅激励了生态系统内的参与和贡献,还为 AI 初创公司和工程师提供了一个全面的支持平台,推动了 AI 技术的发展和应用。

io.net 在激励模型上下足了功夫,保证整个生态系统可以正向循环。io.net 的目标是为网络中每张 GPU 卡建立一个以美元表示的直接小时费率。这需要提供一个清晰、公平且去中心化的 GPU/CPU 资源定价机制。

作为一个双边市场,激励模型的核心关键是旨在解决两大挑战:一方面降低租用 GPU/CPU 计算能力的高昂成本,这对于扩大 AI 和 ML 算力需求关键指标;另一方面解决在 GPU 云服务提供商中租用 GPU 节点的短缺问题。

因此在设计原则上,需求方面的考量包括竞争对手的定价和可用性,以在市场上提供有竞争力和吸引力的选择,并在高峰时段和资源紧张时调整定价。

算力供应方面,io.net 着眼于两个关键市场:游戏玩家和加密 GPU 矿工。游戏玩家拥有高端硬件和快速的互联网连接,但通常只拥有一张 GPU 卡;而加密 GPU 矿工拥有大量的 GPU 资源,尽管可能面临互联网连接速度和存储空间的限制。

因此,算力定价模型包括多维度因素,如硬件性能、互联网带宽、竞争对手定价、供应可用性、高峰时段调整、承诺定价和地点差异。此外,还需要考虑硬件进行其他工作证明加密挖矿时的最佳利润。

未来,io.net 会进一步给出一套完全去中心化定价的方案以及为矿工硬件创建一个类似 speedtest.net 的基准测试工具,打造一个完全去中心化、公平、透明的市场。

io.net 推出了 Ignition 活动,这是 io.net 社区激励计划的第一阶段,目的是加速 IO 网络的增长。

计划总共设有三个奖励池,它们之间完全独立。

这三个奖励池之间是完全独立的,参与者可以从这三个奖励池中分别获得奖励,并且不需要将相同的钱包与每个奖励池关联起来。

对于已经接入的节点,空投积分根据是从 2023 年 11 月 4 日 - 2024 年 4 月 25 日 活动结束时计算。Ignition 活动结束时,用户所赚取的空投积分都会转换为空投奖励。

空投积分会考量四方面: A. 被雇佣的时间 (Ratio of Job Hours Done - RJD) 从 2023 年 11 月 4 日开始到活动结束被雇佣的总时长。

B. 带宽 (Bandwidth - BW) 根据带宽速度范围来对节点的带宽进行等级分类:

低速:下载速度 100MB/每秒,上传速度 75MB/每秒。

中速:下载速度 400MB/每秒,上传速度 300MB/每秒。

高速:下载速度 800MB/每秒。

C. GPU 型号 (GPU Model - GM)将会根据 GPU 型号决定,性能越高的 GPU 积分越多。

D. 成功运行的时间 (Uptime - UT) 从 2023 年 11 月 4 日接入 Worker 开始到活动结束的总共成功运行的时长。

值得注意的是空投积分预计在 2024 年 4 月 1 日左右可供用户查看。

银河任务连接地址 https://app.galxe.com/quest/io.net/GCD5ot4oXP

该奖励将由 io.net 的社区管理团队监督进行,并要求用户在 Discord 中提交正确的 Solana 钱包地址。

将会根据用户的贡献度,活跃度,内容创作等参与其他活动来获取相应的 Airdrop Tier Role 等级。

总的来说,io.net 和类似的去中心化 AI 计算平台正在开启 AI 计算新的篇章,虽然也面临技术实现的复杂性、网络的稳定性和数据安全性的挑战。但 io.net 有潜力彻底改变 AI 商业模式。相信随着这些技术的成熟和算力社区的扩大,去中心化 AI 算力可能成为推动 AI 创新和普及的关键力量。

作者:Biteye 核心贡献者 Fishery

编辑:Biteye 核心贡献者 Crush

社区:@BiteyeCN